今天学习了4个小时 Python - 20231107

早上来公司看了 Open AI 年度开发者大会,AI 时代一日十年,在 AI 时代速度发展已经突破了摩尔定律,这样的速度太可怕了。

现在 AI 是可以自然语言编程的,我直接让 ChatGPT 给我生成代码,然后我本地运行不起来,我完全零基础,我在 B站找了个视频,用 2 倍速看了 2-3 个小时,把本地基本环境做好了。

接下来我跟 ChatGPT 对话,我要采集我自己的博客,我就直接问它

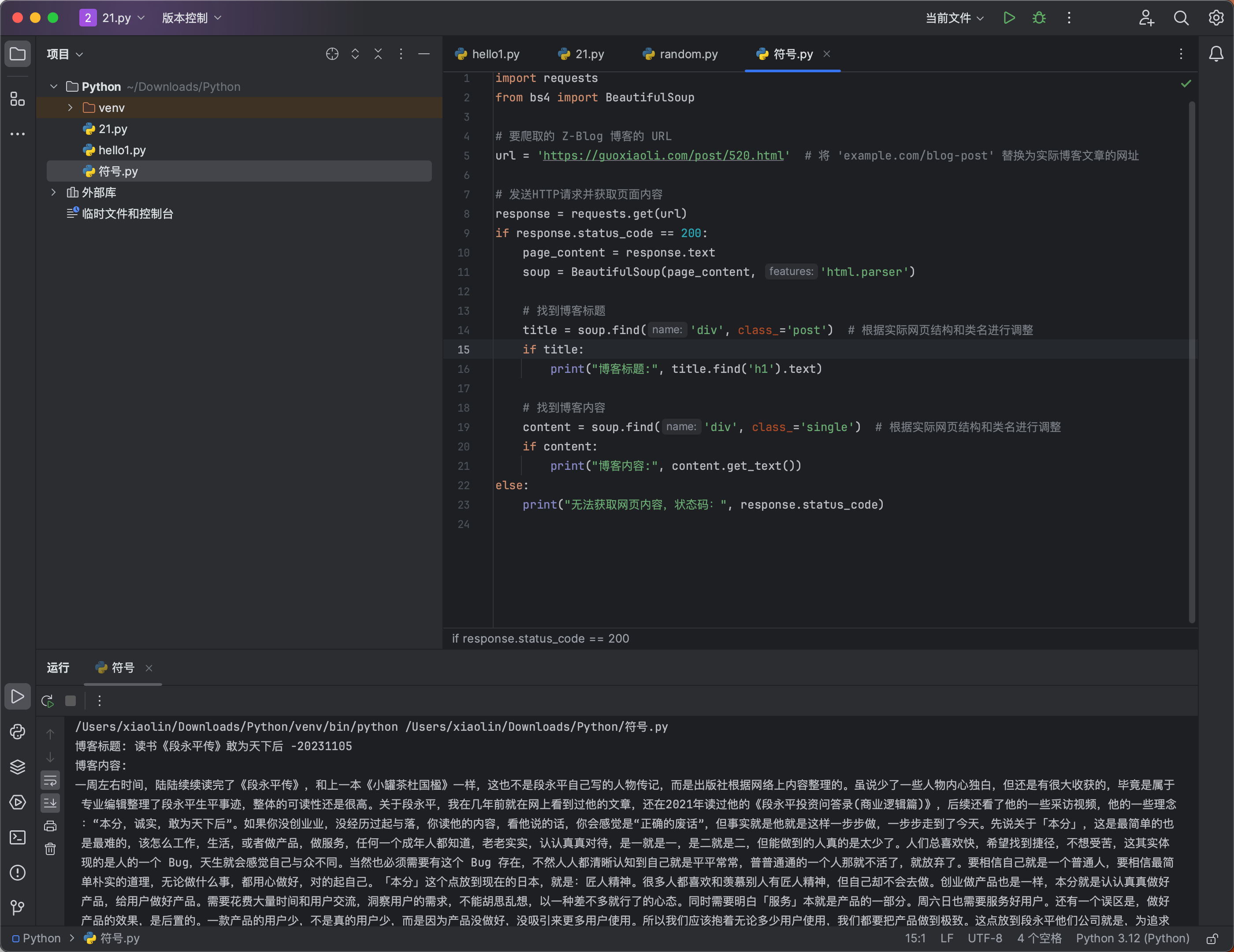

它回答完,我就直接复制代码,改改 Div 名称,成功了一半,内容可以采集了,但标题还是采集不出来,我期间自己尝试改,找百度、知乎、CSDN 等都没解决。最后我又接着问 ChatGPT,我问它,如何取指定 Div 中的内容,它告诉我了,我微调整了下,最后成功了。

最后成功了,可以成功采集到我自己博客的一篇内容。真的有一点点小成就感。

import requests

from bs4 import BeautifulSoup

# 要爬取的 Z-Blog 博客的 URL

url = 'https://guoxiaoli.com/post/520.html' # 将 'example.com/blog-post' 替换为实际博客文章的网址

# 发送HTTP请求并获取页面内容

response = requests.get(url)

if response.status_code == 200:

page_content = response.text

soup = BeautifulSoup(page_content, 'html.parser')

# 找到博客标题

title = soup.find('div', class_='post') # 根据实际网页结构和类名进行调整

if title:

print("博客标题:", title.find('h1').text)

# 找到博客内容

content = soup.find('div', class_='single') # 根据实际网页结构和类名进行调整

if content:

print("博客内容:", content.get_text())

else:

print("无法获取网页内容,状态码:", response.status_code)我能采集一篇,我就可以采集全站,我能采集下来,我就能存到本地/线上的一个数据库中。

我能采集我的博客, 我就可以采集任何人/任何网页的内容了,我用几个小时学会了一项技能。

如果没 ChatGPT,我想我一天也学不会,因为在搜索引擎中搜几次找不到答案,我可能就会放弃。

ChatGPT,不是一个产品,它是一个标配,只要你会用它,人人都可以用自然语言编程,注意,不是未来可以,是现在就可以!

未来就不需要编程了,全部是个人助理,甚至不止一个。